2025-12-23:MIPL的1篇综述论文被CJE(《电子学报(英文版)》)接收

MIPL的1篇综述论文被接收。

细粒度多模态大模型综述

A Survey on Fine-Grained Multimodal Large Language Models

作者:彭宇新,王梓烁(硕士生),李耕(博士生),郑翔天(博士生),尹思博(博士生),何胡凌霄(博士生)

通讯作者:彭宇新

论文链接:https://cje.ejournal.org.cn/article/doi/10.23919/cje.2025.00.336

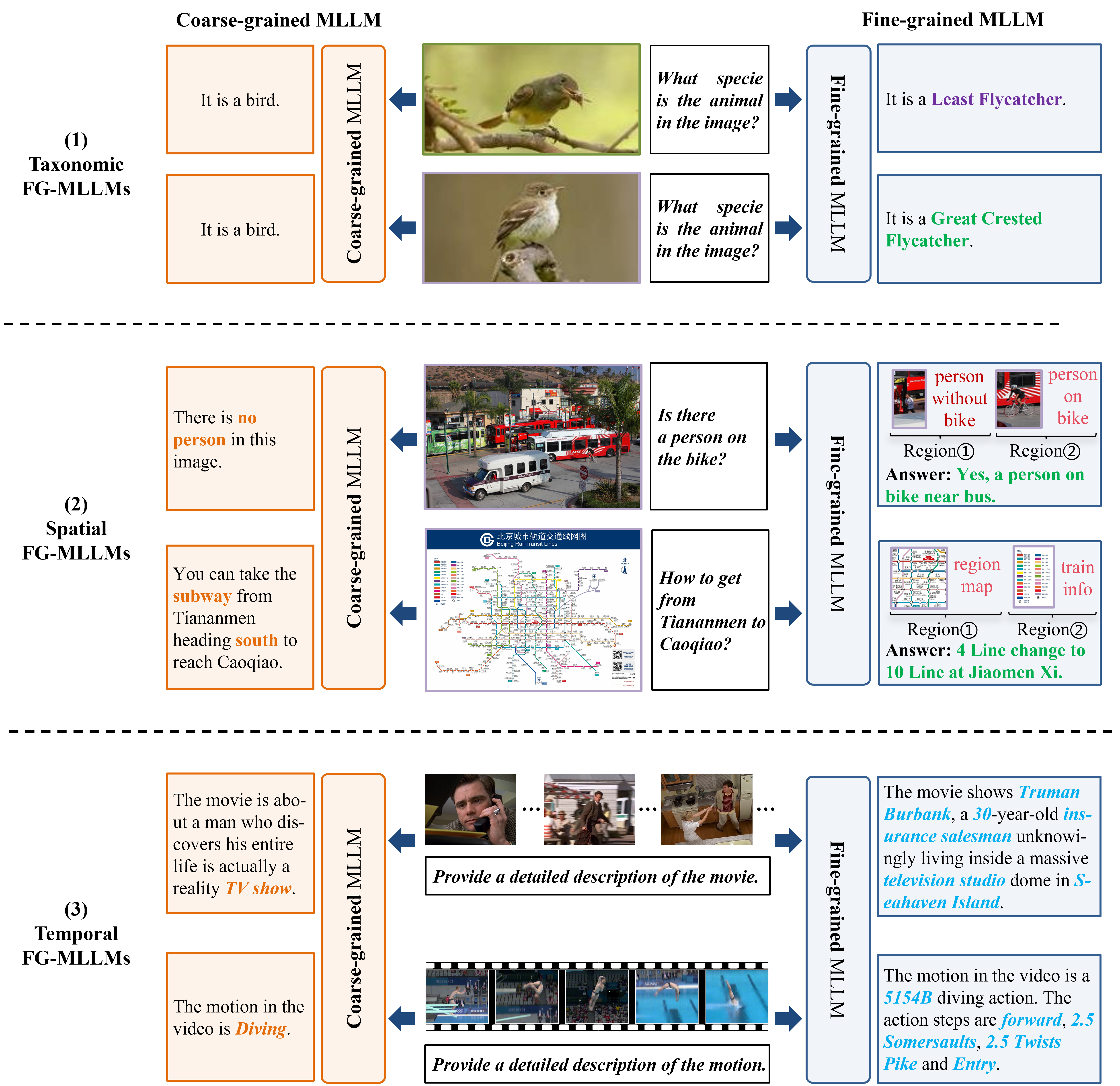

GPT、Gemini、LLaVA等多模态大模型(Multimodal Large Language Models,MLLMs)在视觉问答、图像描述等通用视觉语言任务上取得了显著进展,但其核心能力主要来源于弱监督预训练和微调,还停留在粗粒度感知层面,缺乏细粒度感知能力。例如在Stanford Cars细粒度车辆分类任务上,GPT-4和Claude3的准确率仅为58.2%和45.1%,显著低于 CLIP-L模型的77.5%。这种细粒度感知能力的缺失严重制约了MLLMs在自动驾驶、具身智能、医疗影像、工业制造等对精度要求极高的领域的广泛应用。然而,当前的细粒度多模态大模型研究碎片化,缺乏统一定义,且在任务目标、实验设置和评测基准上都有明显差异。

针对上述问题,本综述从人类视觉系统的“双流假设”(Two-Streams Hypothesis)出发,将视觉感知分解为“识别对象”、“确定位置”与“跟踪变化”三个基础阶段,并据此建立了细粒度多模态大模型的三维分类体系:(1)类别细粒度(Taxonomic FG-MLLMs):区分同一大类下高度相似的不同子类别。例如,不仅识别出“鸟”,更能区分“大冠蝇霸鹟”与“阿卡迪亚霸鹟”等具体鸟类物种。(2)空间细粒度(Spatial FG-MLLMs):在高分辨率输入中对微小、密集或语义复杂的区域进行定位与识别。不仅检测显著物体,还能精准定位复杂场景中的特定目标或理解精细的局部细节。(3)时间细粒度(Temporal FG-MLLMs):在视频中定位和理解事件或动作,不仅生成视频摘要,还能精确定位动作的时间边界,并将复杂动作分解为子动作进行时序分析。本综述进一步分析了多模态大模型细粒度感知能力弱的三大原因:(1)模型架构在细粒度特征建模上的不足、(2)高质量细粒度标注数据稀缺、(3)细粒度感知与计算效率之间的矛盾,最后探讨了细粒度多模态大模型未来的发展方向。

该论文的第一作者和通讯作者是北京大学王选计算机研究所彭宇新教授,与硕士生王梓烁、博士生李耕、郑翔天、尹思博、何胡凌霄合作完成。