2024-06-17:MIPL学生参加 CVPR 2024

2024年6月17日至21日,国际计算机视觉与模式识别会议(The IEEE/CVF Conference on Computer Vision and Pattern Recognition,CVPR 2024)在美国西雅图召开。王选所MIPL博士生崔振宇、尹思博参加了此次会议。

CVPR每年召开一次,是计算机视觉领域的顶级会议。本次会议吸引了来自学术界、工业界超过一万两千人参加。会议包括口头报告、墙报展示、workshops、tutorials等环节。

本次大会共提交了11532篇论文,录取2719篇论文,录取率为23.6%,其中Oral论文占比3.3%,Highlight论文占比11.9%。王选所MIPL师生共发表4篇论文,论文信息如下:

[1] Jinglin Xu, Sibo Yin, Guohao Zhao, Zishuo Wang and Yuxin Peng*, "FineParser: A Fine-grained Spatio-temporal Action Parser for Human-centric Action Quality Assessment", 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle WA, USA, June 17 - 21, 2024, (Oral, 3.3%).

该论文针对动作质量评估任务(Action Quality Assessment,AQA)提出以人为中心的时空动作解析方法:首先设计空间动作解析器(SAP),用以捕获以人为中心的前景动作的多尺度表征,重点关注每一帧的目标动作区域,保证在空间解析的有效性。其次设计时间动作解析器(TAP),通过学习视频的时空表征将目标动作解析为连续的步骤来建模人体动作的语义一致性和时间相关性。然后设计静态视觉编码器(SVE),通过捕获每一帧详细的上下文信息来增强目标动作表征。最后设计细粒度对比回归器(FineReg)捕获成对目标动作步骤之间的细粒度差异,并评估动作质量。

尹思博同学做口头报告

尹思博同学做墙报展示

[2] Jinglin Xu, Yijie Guo and Yuxin Peng*, "FinePOSE: Fine-Grained Prompt-Driven 3D Human Pose Estimation via Diffusion Models", 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle WA, USA, June 17 - 21, 2024, (Highlight, 11.9%).

该论文针对三维人体姿态估计任务提出了基于扩散模型的细粒度提示驱动的三维人体姿态估计方法,首先对文本信息和人体自然先验知识进行编码,其次将编码特征与可学习提示相结合,构建基于细粒度姿态感知的可学习提示,然后在所学的提示与带噪的三维人体姿态表征之间建立细粒度的通信,以增强扩散模型的去噪能力。

[3] Jinglin Xu, Guohao Zhao, Sibo Yin, Wenhao Zhou and Yuxin Peng*, "FineSports: A Multi-person Hierarchical Sports Video Dataset for Fine-grained Action Understanding", 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle WA, USA, June 17 - 21, 2024.

该论文针对时空定位任务中缺少细粒度标注数据集的问题,提出了一个新的多人场景的体育运动视频数据集FineSports,该数据集包含12个粗粒度和52个细粒度动作类别,以及密集标注的球员空间边界和动作时间边界。论文还提出了时空动作定位方法PoSTAL,由提示驱动的目标动作编码器PTA和目标动作时空检测器ATD组成;首先利用PTA模块在描述性提示的引导下提取目标动作特征,然后将其送入ATD模块同时获得目标动作tube和相应的细粒度动作类型,无需进行候选区域的生成,提高了时空定位的准确性。

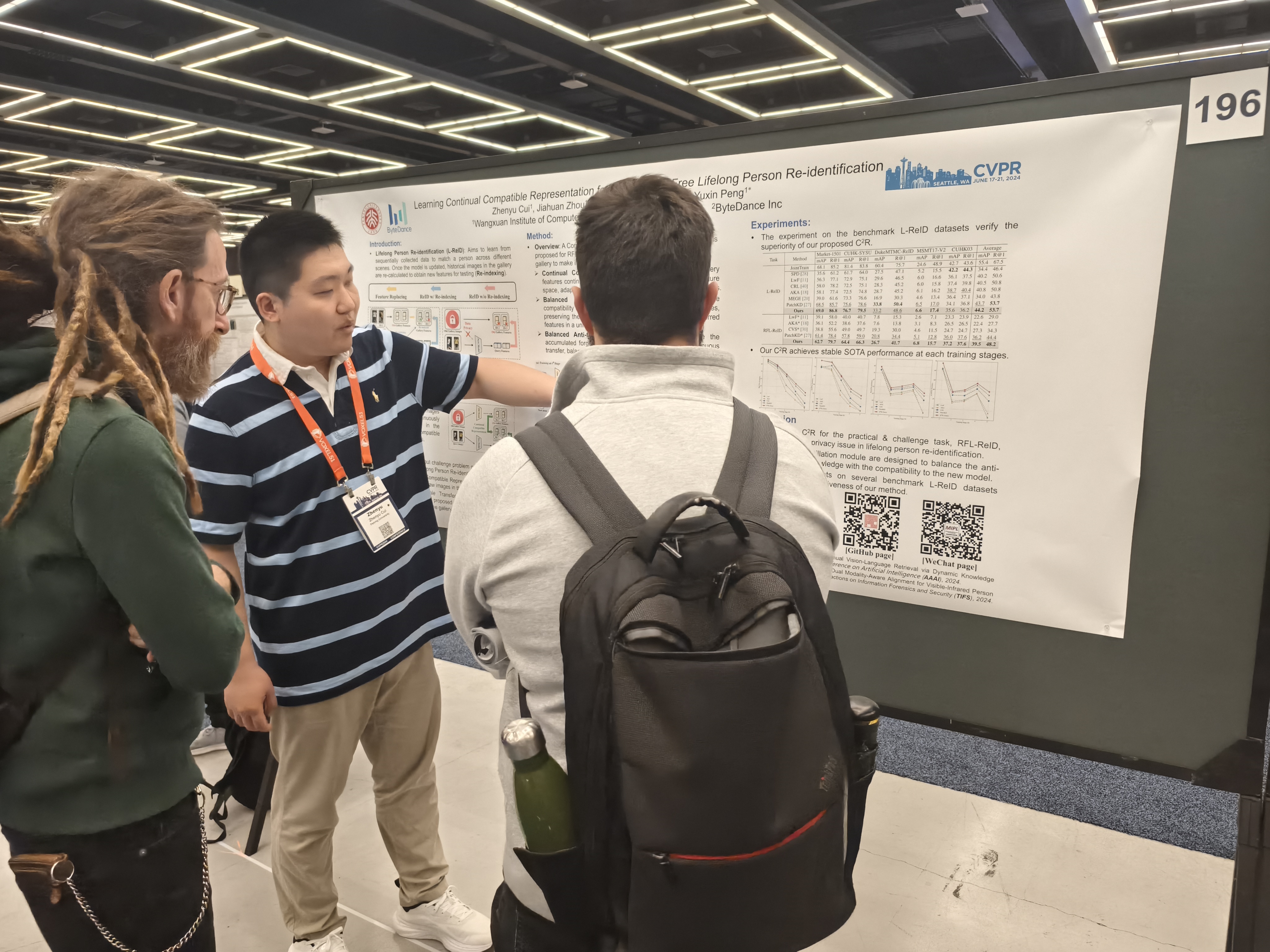

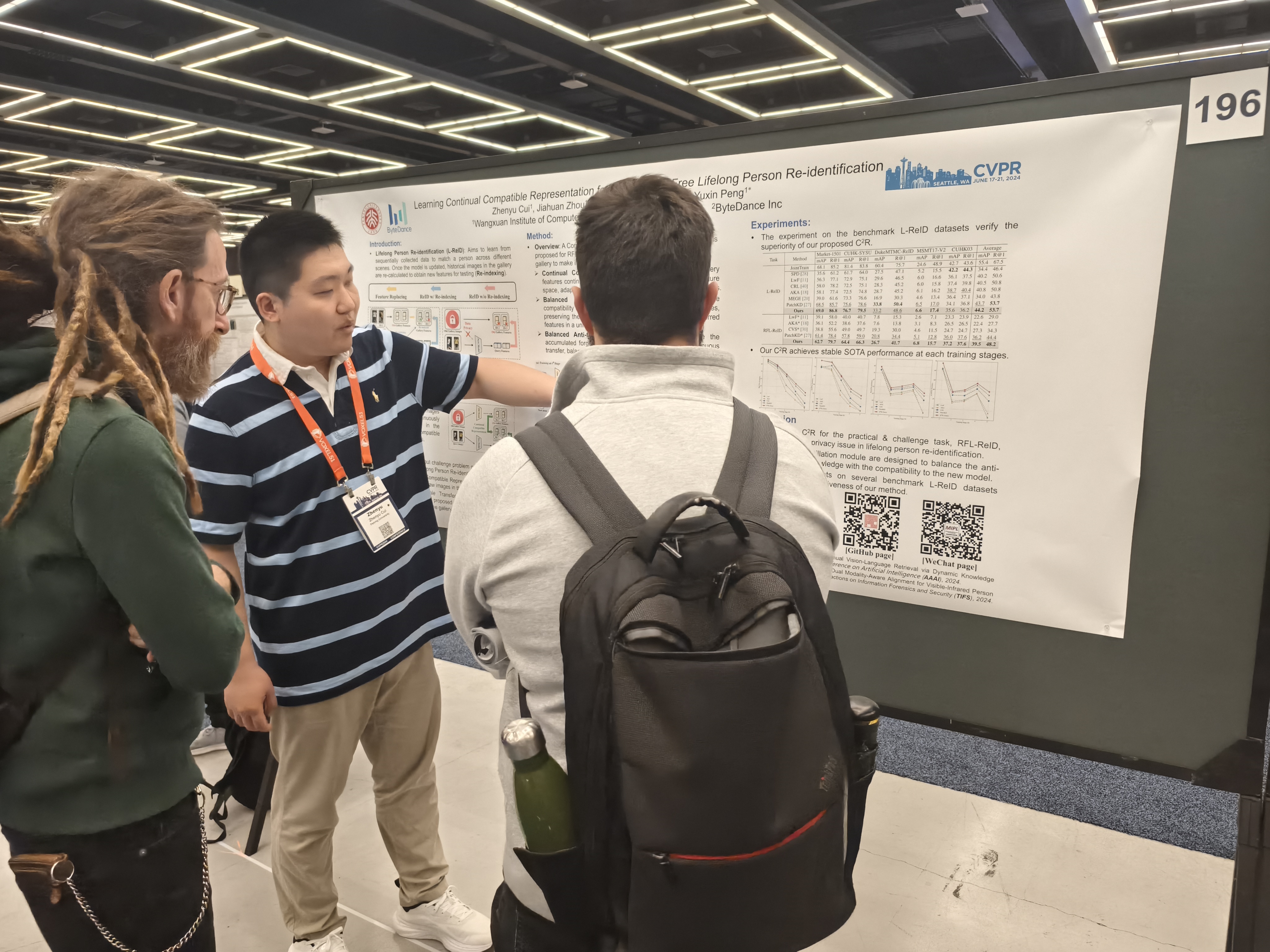

[4] Zhenyu Cui, Jiahuan Zhou, Xun Wang, Manyu Zhu and Yuxin Peng*, "Learning Continual Compatible Representation for Re-indexing Free Lifelong Person Re-identification", 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle WA, USA, June 17 - 21, 2024.

该论文针对终身行人重识别任务提出基于持续兼容表征学习框架(C2R):首先提出持续兼容转移网络,将旧模型提取的已知行人特征转移到新特征空间中。然后,提出平衡兼容蒸馏学习模块,通过最小化新特征和转移后特征间距离,并保持新旧特征间相似度关系,提升转移后特征兼容性。最后,提出平衡抗遗忘蒸馏学习模块,通过最小化新旧特征分类结果,并保持转移前后特征向量间的余弦相似度,提升转移后特征的鉴别性。该方法能避免传统行人重识别算法升级后由于依赖旧数据库中图像而导致的数据隐私问题,实现行人重识别算法的快速升级与部署。

崔振宇同学做墙报展示

CVPR每年召开一次,是计算机视觉领域的顶级会议。本次会议吸引了来自学术界、工业界超过一万两千人参加。会议包括口头报告、墙报展示、workshops、tutorials等环节。

MIPL博士生会场合影(左:崔振宇,右:尹思博)

本次大会共提交了11532篇论文,录取2719篇论文,录取率为23.6%,其中Oral论文占比3.3%,Highlight论文占比11.9%。王选所MIPL师生共发表4篇论文,论文信息如下:

[1] Jinglin Xu, Sibo Yin, Guohao Zhao, Zishuo Wang and Yuxin Peng*, "FineParser: A Fine-grained Spatio-temporal Action Parser for Human-centric Action Quality Assessment", 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle WA, USA, June 17 - 21, 2024, (Oral, 3.3%).

该论文针对动作质量评估任务(Action Quality Assessment,AQA)提出以人为中心的时空动作解析方法:首先设计空间动作解析器(SAP),用以捕获以人为中心的前景动作的多尺度表征,重点关注每一帧的目标动作区域,保证在空间解析的有效性。其次设计时间动作解析器(TAP),通过学习视频的时空表征将目标动作解析为连续的步骤来建模人体动作的语义一致性和时间相关性。然后设计静态视觉编码器(SVE),通过捕获每一帧详细的上下文信息来增强目标动作表征。最后设计细粒度对比回归器(FineReg)捕获成对目标动作步骤之间的细粒度差异,并评估动作质量。

[2] Jinglin Xu, Yijie Guo and Yuxin Peng*, "FinePOSE: Fine-Grained Prompt-Driven 3D Human Pose Estimation via Diffusion Models", 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle WA, USA, June 17 - 21, 2024, (Highlight, 11.9%).

该论文针对三维人体姿态估计任务提出了基于扩散模型的细粒度提示驱动的三维人体姿态估计方法,首先对文本信息和人体自然先验知识进行编码,其次将编码特征与可学习提示相结合,构建基于细粒度姿态感知的可学习提示,然后在所学的提示与带噪的三维人体姿态表征之间建立细粒度的通信,以增强扩散模型的去噪能力。

[3] Jinglin Xu, Guohao Zhao, Sibo Yin, Wenhao Zhou and Yuxin Peng*, "FineSports: A Multi-person Hierarchical Sports Video Dataset for Fine-grained Action Understanding", 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle WA, USA, June 17 - 21, 2024.

该论文针对时空定位任务中缺少细粒度标注数据集的问题,提出了一个新的多人场景的体育运动视频数据集FineSports,该数据集包含12个粗粒度和52个细粒度动作类别,以及密集标注的球员空间边界和动作时间边界。论文还提出了时空动作定位方法PoSTAL,由提示驱动的目标动作编码器PTA和目标动作时空检测器ATD组成;首先利用PTA模块在描述性提示的引导下提取目标动作特征,然后将其送入ATD模块同时获得目标动作tube和相应的细粒度动作类型,无需进行候选区域的生成,提高了时空定位的准确性。

[4] Zhenyu Cui, Jiahuan Zhou, Xun Wang, Manyu Zhu and Yuxin Peng*, "Learning Continual Compatible Representation for Re-indexing Free Lifelong Person Re-identification", 37th IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle WA, USA, June 17 - 21, 2024.

该论文针对终身行人重识别任务提出基于持续兼容表征学习框架(C2R):首先提出持续兼容转移网络,将旧模型提取的已知行人特征转移到新特征空间中。然后,提出平衡兼容蒸馏学习模块,通过最小化新特征和转移后特征间距离,并保持新旧特征间相似度关系,提升转移后特征兼容性。最后,提出平衡抗遗忘蒸馏学习模块,通过最小化新旧特征分类结果,并保持转移前后特征向量间的余弦相似度,提升转移后特征的鉴别性。该方法能避免传统行人重识别算法升级后由于依赖旧数据库中图像而导致的数据隐私问题,实现行人重识别算法的快速升级与部署。